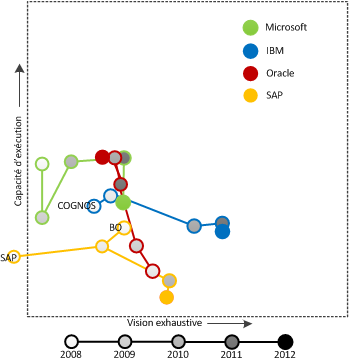

Gartner a publié il y a quelques mois la version 2013 de son quadrant magique (Magic Quadrant) pour les plateformes de Business Intelligence (BI). Le quadrant magique positionne les fournisseurs de plateformes BI les uns par rapport aux autres.

Dans la présente analyse, je tente de comprendre comment se sont déplacés les quatre grands fournisseurs de plateformes BI (Microsoft, Oracle, IBM et SAP) sur cet échiquier et pourquoi. Je me se réfère aux quadrants Gartner des cinq dernières années. J’avais publié un exercice similaire sur ce blog l’année dernière.

Le quadrant magique comporte deux axes sur lesquels sont positionnés les principaux fournisseurs. Afin de bien comprendre ce classement, reprenons l’explication donnée l’année dernière sur ce blog (pour plus de détails consultez l’explication donnée par Gartner):

« L’axe capacité d’exécution (vertical) qualifie la capacité de la firme à fournir un produit de qualité à ses clients et sa capacité à poursuivre son investissement dans ce produit dans le futur. On parle de capacité à livrer et de satisfaction client. L’axe vision exhaustive concerne plutôt la capacité de la firme à comprendre les besoins du marché et à développer une plateforme qui réponde à l’ensemble de ces besoins. Il s’agit beaucoup d’innovation. »

Le quadrant de Gartner est divisé en quatre zones. Les firmes qui performent le mieux dans l’étude se retrouvent dans le coin supérieur droit. Ce sont les leaders du marché. Cette position convoitée par les fournisseurs de plateformes BI est occupée, en 2013, par 10 firmes, soit deux de plus que l’année dernière. Les huit leaders de 2012 sont toujours là en 2013 : Microsoft, Oracle, IBM, SAP, MicroStrategy, Information Builders, SAS et QlikTech. Les deux nouveaux sont Tableau Software et Tibco Software. Le graphique ci-dessous représente le mouvement des quatre fournisseurs qui nous intéressent plus particulièrement sur les cinq dernières années.

Microsoft

En 2013, Microsoft s’illustre clairement comme leader sur l’axe « capacité d’exécution », ce qui démontre sa capacité à livrer et à satisfaire ses clients.

L’offre BI de Microsoft est principalement concentrée dans trois produits : EXCEL (PivotTable, PowerPivot, PowerView), SQL Server (SSRS, SSAS, SSIS) et Sharepoint. La sortie de SQL Server 2012, PowerView et EXCEL 2013 a certainement favorisé Microsoft sur les deux axes. PowerView vient compléter l’offre de Microsoft avec un outil puissant d’exploration de données en mode libre-service.

L’étude de Gartner révèle aussi que SQL Server 2012 a reçu des notes nettement au-dessus de la moyenne du côté de la gestion des métadonnées, de l’intégration à Office, du OLAP, du ad hoc query et des outils de développement. L’étude de Gartner précise que les notes obtenues pour SQL Server 2012 sont nettement plus élevées que celles obtenues pour SQL Server 2008/R2.

Un fait intéressant à souligner : les parts de marché de Microsoft ne cessent de croitre depuis son entrée dans le marché du BI et les prévisions de Gartner sont qu’elles continueront à croitre. Leur étude révèle que le coût total d’acquisition (TCO) avantage grandement Microsoft par rapport à ses rivales.

Microsoft tarde toujours à se positionner du côté de la mobilité. On ne retrouve pas pas de facilitant dans l’offre de Microsoft, autant du côté de Reporting Services que du côté de PowerView, pour faciliter le développement et le déploiement sur plateforme mobile.

Microsoft se distingue nettement du côté du reporting et de l’analyse des données, mais elle est devancée par les IBM, SAP et Oracle du côté du Corporate Performance Management (CPM) qui incorpore généralement des capacités de planning et budgeting. Les trois autres firmes offrent en effet un produit dédié au CPM ce que ne fait pas Microsoft.

IBM

IBM se positionne depuis plusieurs années comme le leader sur l’axe « vision exhaustive », ce qui démontre une excellente vision des besoins du marché et une bonne innovation.

L’offre d’IBM se concentre autour de COGNOS (BI standard) et SPSS (analyse prédictive). IBM propose de nouveaux produits innovateurs tel Analytic Answers, une solution d’analyse prédictive et prescriptive et mode service, et COGNOS Insight, un outil d’exploration de données en mode libre-service.

Le tendon d’Achille de COGNOS reste la performance. Les problèmes de performance identifiés avec COGNOS 8 ont nui à l’image de COGNOS selon Gartner. L’autre reproche qui est fait à COGNOS est la difficulté d’utilisation. Gartner relate que produire un rapport avec COGNOS prend presque deux fois plus de temps, en moyenne, qu’avec les plateformes concurrentes. IBM a tenté de simplifier la construction de rapports avec COGNOS 10, ceci aura certainement un impact sur les résultats de la prochaine étude. D’ailleurs Gartner prédit que COGNOS aura de meilleurs résultats avec COGNOS 10 à plusieurs égards, dont la qualité des produits et du support.

Oracle

Oracle consolide sa position dans le quadrant. L’offre d’Oracle est très exhaustive. OBIEE et Essbase y occupent un rôle central. La force d’Oracle est de bien supporter la mise en place de solutions BI centralisées à large déploiement, dirigées par les TI et basées sur une métadonnée unifiée. Sa large gamme d’outils offre des capacités de reporting, d’analyse avancée et de CPM. Une des forces d’OBIEE est du côté de ses capacités de tableaux de bord : c’est sur cet aspect qu’Oracle se classe le mieux dans l’étude de Gartner. Une des forces d’Oracle est aussi d’offrir des solutions BI intégrées à ses solutions d’affaires comme E-Business Suite (EBS), PeopleSoft, JD Edwards et Siebel, ce qui est très apprécié de sa clientèle. Oracle propose plus de 80 solutions BI prédéveloppées incorporant l’ETL, les modèles de données et des banques d’indicateurs de performance (KPI) pour divers domaines d’application.

Oracle a été plus lente que ses concurrentes à offrir des capacités de vue composite (mashup) et de visualisation interactive. Oracle tarde aussi à offrir une solution mobile multiplateforme (limité à iOS actuellement). Le temps de développement de rapports plus long que la moyenne ainsi qu’un pointage faible sur la facilité d’utilisation, autant du côté des utilisateurs finaux que des développeurs, tirent la cote d’Oracle vers le bas sur l’axe « capacité d’exécution ». Autre ombre au tableau : plusieurs clients d’Oracle continuent à être insatisfaits de la qualité du produit et du support.

SAP

SAP se distingue sur l’axe « vision exhaustive » avec une plateforme complète et plusieurs nouvelles acquisitions, mais continue à glisser sur l’axe « capacité d’exécution » dû à des problèmes de stabilité et à un support à la clientèle déficient, selon l’étude de Gartner.

Du reporting classique à l’analyse prédictive en passant par l’analyse en mémoire et le big data, l’offre BI de SAP est très complète. Ses principaux produits sont BusinessObjects, SAP NetWeaver Business Warehouse et Hana. À l’instar de sa rivale Oracle, SAP mise sur une offre intégrée à ses applications d’affaires déjà en place dans son vaste bassin de clientèle. Les organisations ayant SAP comme ERP vont plus naturellement se tourner vers les solutions BI prédéveloppées que propose SAP. Cet avantage confère à SAP le plus grande part du marché du BI. SAP se distingue aussi des trois fournisseurs sur lesquels nous nous concentrons par ses facilitants pour le BI mobile avec son SAP Mobile Platform (connu ces dernières années sous le nom Sybase Unwired Platform) qui facilite le développement tout en permettant la gestion du déploiement et de la sécurité.

SAP performe moins bien que ses concurrentes du point de vue de la qualité du logiciel (instabilité et fiabilité) et du support à la clientèle, deux aspects importants sur l’axe « capacité d’exécution ». Problème classique pour une société qui fait beaucoup d’acquisitions : l’interopérabilité des composantes devient un casse-tête. La complexité de développement des rapports semble aussi un point négatif à considérer : presque deux fois plus long qu’avec les plateformes concurrentes.

Consultez le rapport de Gartner, il souligne les forces et faiblesses de chaque offre de manière beaucoup plus détaillée.

Figure 1 – Le quadrant magique en cinq temps

Figure 1 – Le quadrant magique en cinq temps